Często bardziej świadomi klienci pytają mnie jak to jest z tym rozliczeniem się za działania SEO. Modeli rozliczeń jest wiele, w uproszczeniu za efekt / stały abonament / liczba godzin, podjętych działań. Czy w przyszłości przy rażąco większym udziale LLMów do serwowania wyników to się zmieni?

Kontekst, czyli LLM

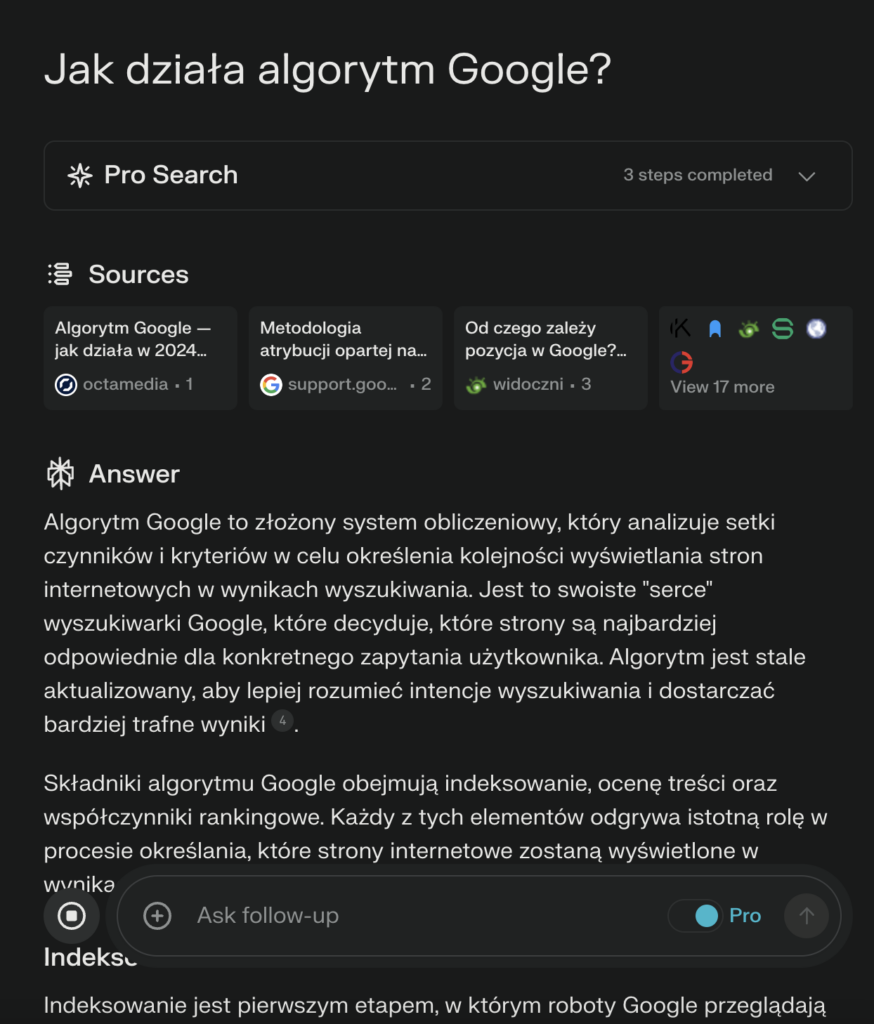

LLMy to duże modele językowe. Jeden z popularnie znanych to chociażby od OpenAI – GPT na dzień 16.03. GPT w wersji 4. Aktualnie nie ma wielu wybijających się modeli językowych, które sprawnie przeszukują internet. Jednym z pierwszych jaki przyjdzie nam na myśl w kontekście SEO, będzie zapewne Gemini (dawniej Bard) od Google. Istnieją też bardziej konkurencyjne jak Perplexity.

Nowy sposób wyszukiwania w sieci

Kiedy już wiemy czym są LLMy i znamy przynajmniej ze dwa rozwiązania (mam nadzieję, że sprawdziłeś Gemini i/lub Perplexity) to zastanówmy się teraz, czy za kilka lat użytkownicy nie będą zupełnie inaczej przeglądać sieci i wyszukiwać informacji?

Jeśli zastanawiasz się, po co o tym dyskutujemy, to koniecznie przetestuj powyższe narzędzia. Zobacz również jak działają aplikacje mobilne Perplexity oraz bardziej „darmowa” ale jednak eksperymentalna wersja Arc Search na iOS.

W dużym uproszczeniu te narzędzia dają w większości przypadków skuteczne odpowiedzi na zadanie pytania. Otrzymujesz wynik bez konieczności generowania ruchu organicznego „realnego użytkownika” na stronach z których treści zostały opracowane i zaserwowane Tobie w postaci gotowej odpowiedzi. (czasem nawet już sparafrazowanej pod Ciebie, językiem który lepiej zrozumiesz.)

Ekspresowe serwowanie wyników przez AI

Jeśli wpiszesz zapytanie, LLM przygotuje dla Ciebie wyniki. Wyświetli odpowiedź. Jeśli będzie to spersonalizowane narzędzie, to wynik zostanie odpowiedni dla Ciebie podany. Czyli użytkownik dostanie to, o co algorytmy Google walczą od wieków: szybkie odnalezienie poszukiwanych informacji. Czyli zaserwowanie wyników zgodnych z oczekiwaniem wyszukującego. Podając oczywiście źródła skąd informacja została przygotowana. Tak, aby ciągle nieufnie spoglądający na rezultat działania AI operator mógł zweryfikować czy przypadkiem nie doszło do jakiś „halucynacji” modelu. Jak wiemy, aktualne modele językowe są dość w początkowej fazie swoich możliwości. A przecież i tak już wykorzystywane są na potęgę.

To co dalej z SEO?

Pozycjonowanie i optymalizacja to nie tylko zdobywanie linków i wpływanie na tzw. „Czynnik linków” to również optymalizacja techniczna (metadane) oraz inne techniczne aspekty. One mają i dalej będą mieć znaczenie. Bowiem LLMy swoje przeszukiwania muszą opierać nie tylko na świetnie napisanych tekstach. Swoje odpowiedzi będą modelować również na podstawie wspomagania przez metadane na stronach internetowych. Dodatkowe działania SEO bedą się opierać (bardzo możliwe) na „dokarmianiu” umiejętnym dużych modeli językowych. To będzie coś więcej niż tylko inteligentne, oparte już na technologach AI algorytmy wyszukiwarki. Warto śledzić rozwój tych narzędzi i bardzo powolny, ale jednak wzrost udziału ich w rynku pozyskiwania informacji w sieci Internet.

Model rozliczenia SEO przy rosnącym udziale AI

Wybiegając w przyszłość, zakładając znaczący wzrost udziały w wyszukiwaniu przez gotowe rozwiązania AI oparte o LLMy, takie jak Perplexity czy Gemini Google, mogą znacząco wpłynąć na ilość odwiedzin / przejść z SERPów na strony internetowe naszych klientów. Co za tym idzie, rozliczania za efekt na sesjach/użytkownikach czy pozycjach na określone frazy, może przejść do lamusa. Bardziej efektywniejsze wydaje się rozliczenie za konkretne leady czy sprzedaż koszykowa np. w % ujęciu. Czas pokaże jak branża SEO będzie realizować rozliczenia za swoją pracą i jak ta praca zmieni się na przestrzeni najbliższej dekady. Z wielkim zainteresowaniem będziemy się temu przyglądać!