Jeśli potrzebujesz własnego darmowego i prywatnego asystenta, spróbuj wykorzystać swój komputer. Zainstaluj ze mną kilka składników, aby w pełni uruchomić własny „czat gpt”. Dzięki tej instrukcji postawisz sprawny duży model językowy. Uruchomimy w oknie przeglądarki prywatnego DeepSeek R1, który nie wysyła żadnych danych do chmury. Nie przedłużajmy, zapraszam!

Instalacja i wymagania

Niezależnie czy korzystasz z MacOS czy Windows, będziesz mógł uruchomić swój własny LLM. Wcześniej pisałem o aplikacji LLM Studio i własnym „czacie GPT” na komputerze tutajLLM Studio i własnym „czacie GPT” na komputerze tutaj. Tym razem, skorzystamy z konkretnie z DeepSeek, o którym głośno od stycznia 2025.

Eksperymenty zalecam wykonywać na kontenerach. Użyjemy więc Dockera.

Docker do pobrania wersja na windows/macOS: docker.com

Ollama do modeli – aby uruchomić. pobierz z ollama.com.

W zależności od mocy swojego komputera, należy pobrać właściwy model DeepSeek. Zalecam na start ten mniejszy, (zajmuje też mniej miejsca ok. 5GB)

ollama pull deepseek-r1

Dla mocniejszego sprzętu, zacznij od deepseek-r1:32b

Uruchomienie własnego AI w interfejsie webowym w przeglądarce.

Aby to zrobić. Uruchom zainstalowany wcześniej program do kontenerów (docker).

Dla osób nie lubiących konsoli, wystarczy pobrać obraz open-webui

![]()

i uruchomić go na porcie np. 3000.

W przypadku konsoli będzie prościej:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

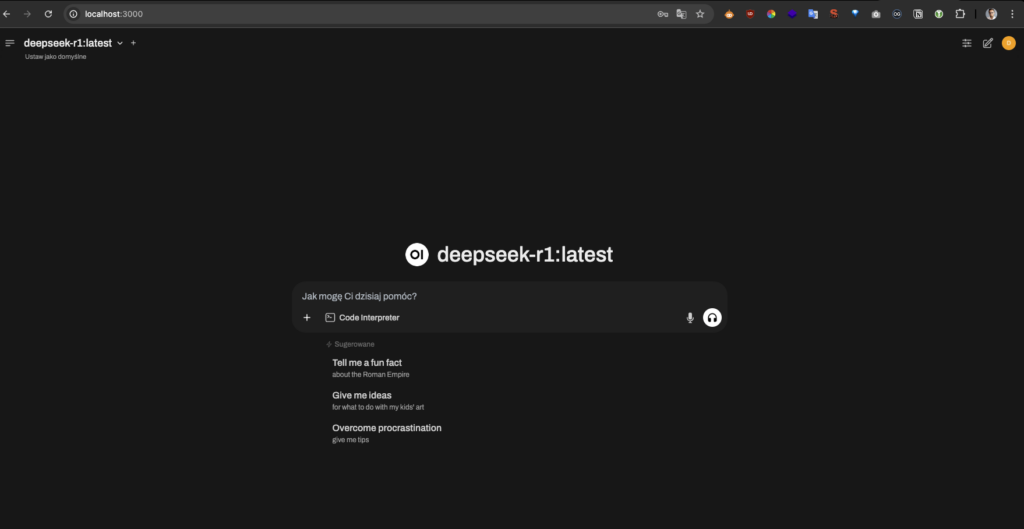

Własny darmowy i prywatny DeepSeek w przeglądarce

Po uruchomieniu powyższego, wystarczy włączyć Ollame oraz założyć lokalne konto. Wówczas Twoim oczom ukaże się własny, darmowy czat AI. Udanej zabawy!